Il y a quelques jours la prestigieuse institution « Imperial College London » a publié un article intitulé « DALL-E-Bot: Introducing Web-Scale Diffusion Models to Robotics ».

L’objectif de cet article et des recherches associées est de démontrer l’interactivité possible entre un robot, la génération d’images par l’IA et l’analyse textuelle via un processus basé sur 𝗗𝗮𝗹𝗹-𝗘.

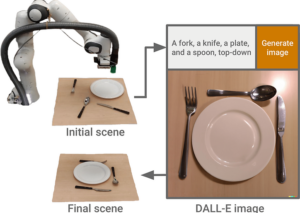

Exemple de réarrangement par l’IA

Le projet est le suivant :

Permettre à un robot (bras articulé dans un premier temps) de réagencer une « scène » (par exemple des couverts, une assiette et un verre) qui étaient disposés de manière aléatoire sur une table, pour la faire correspondre à une représentation finale fournie sous forme de phrases.

Ainsi quand l’utilisateur indique au système : « le verre est au dessus de l’assiette, le couteau à droite etc … » le robot va déplacer « physiquement » les différents objets afin de les faire correspondre à la scène attendue et donc finalement, remettre « proprement » et correctement les couverts disposés sur la table !.

Comme toujours cette expérience se base sur un ensemble de technologies issues de la robotique et de l’IA.

Le système effectue tout un ensemble de tâches séquentielles pour arriver à ses fins :

– Il analyse tout d’abord la scène initiale avec une caméra (avec les couverts/assiette en « vrac « sur la table), découpe l’image fournie en récupérant et détourant les objets présents (fourchette, couteau…) et associe le texte correspondant aux objets via les mécanismes de reconnaissance « classiques ».

– Il analyse ensuite la phrase de description introduite par l’humain pour en extraire la sémantique et les mots clés.

– A partir de ce dictionnaire de mots, il va générer une image représentant l’agencement finale attendue sur la table.

– A partir de cette image, le système va isoler les objets de l’image et les classifier par rapport à ce qu’il a stocké lors de la première phase et donc associer les formes de l’image avec les objets qu’il a intégré dans son référentiel.

– Enfin le système utilise le « plan d’exécution » propre au robot pour déplacer « physiquement » les objets à l’endroit exact où ils sont attendus sur l’image.

A titre d’expérimentation les chercheurs ont testé leur solution sur le réarrangement automatique d’un bureau.

Imaginez, vous retrouvez le matin votre bureau correctement rangé (souris, clavier, moniteur, stylo) alors qu’il était en désordre la veille. Juste avant de partir, vous aviez indiqué au système comment vous souhaitiez ranger vos matériels !

Ce qui est intéressant dans cette expérimentation c’est que cela ne se base pas sur un entrainement (apprentissage) au sens IA du terme (Machine Learning). Le système peut analyser une scène de manière dynamique et effectuer le réarrangements à partir de mots clés sans intervention humaine.

On imagine sans peine l’intérêt pour les chambres de nos chers bambins !